JAR KLOPE NA DVERE, ALE VY NEOTVÁRATE? ZATOČTE S JARNOU ÚNAVOU!

Vtáky každé ráno čvirikajú o sto šesť, stromy kvitnú, dni sa predlžujú a vy konečne môžete zo šatníka vytiahnuť ľahšie kabáty. Problém je, že sa

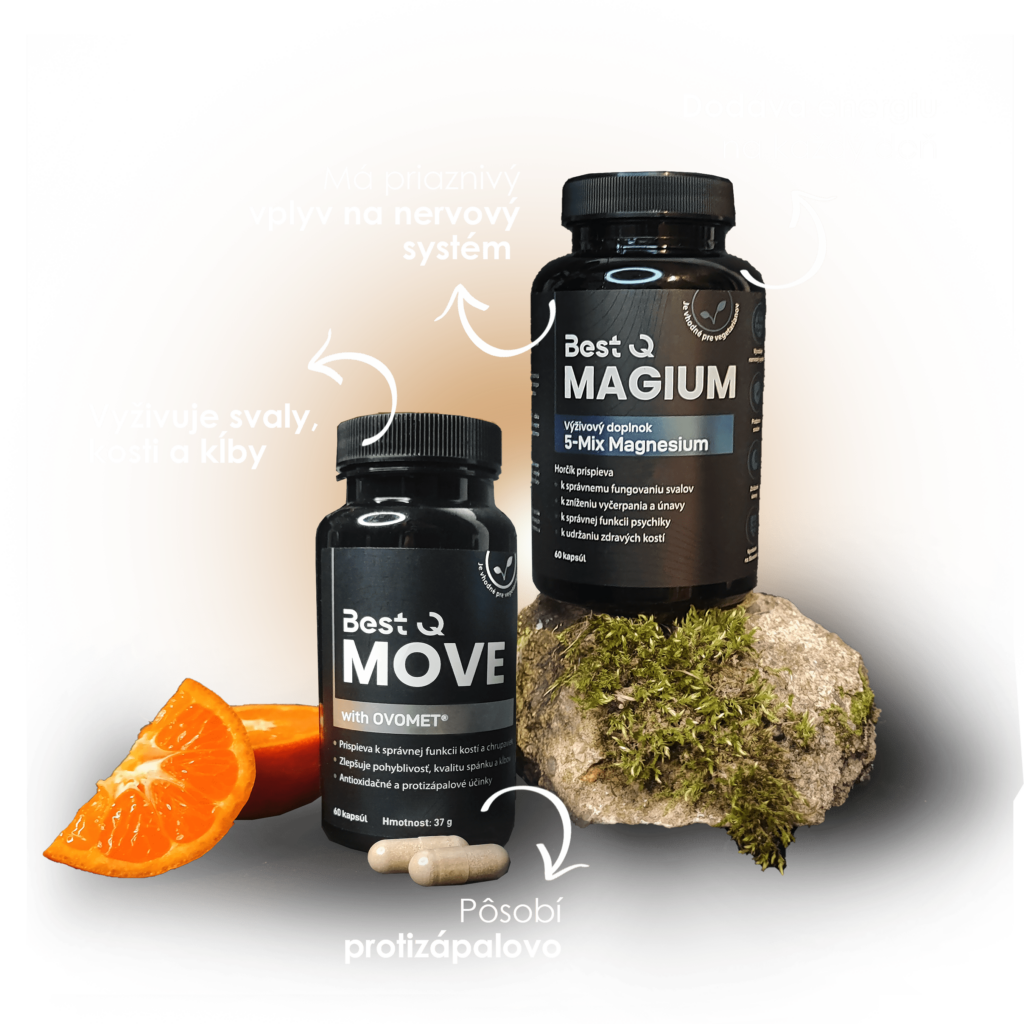

Aby bol pre vás pohyb opäť radosťou, vaše kĺby potrebujú správnu výživu. No aby ste mali silu bojovať za svoje zdravie každý deň, napumpujte sa energiou s horčíkom. Vezmite si na pomoc duo produktov BestQ.

Naše produkty vyrábame na Slovensku z tých najkvalitnejších prírodných surovín. Kapsule Best Q sú vhodné aj pre vegetariánov.

Vtáky každé ráno čvirikajú o sto šesť, stromy kvitnú, dni sa predlžujú a vy konečne môžete zo šatníka vytiahnuť ľahšie kabáty. Problém je, že sa

Zabudnite na Supermana, Batmana či Spidermana. Superhrdina, ktorý vás skutočne podrží v ťažkých časoch, sa volá Mr. Magnesium (s krycím menom horčík). Bojuje proti zlej

Prečo vaše novoročné predsavzatia skončia v koši už vo februári? Urobili ste predsa všetko správne. Nové športové oblečenie, permanentka do fitka, nakúpené činky…nič z toho

* Dajte aj Vy vedieť o svojej skústenosti cez kontaktný formulár.

Môj príbeh, ktorý vyústil do založenia tejto spoločnosti, sa začal písať pred niekoľkými rokmi.

V tej dobe som bol “aktívny nešportovec” a vyznávač nezdravého životného štýlu. Postupne som sa tak prepracoval na takmer 150 kg živej váhy. Pár dní po tom, ako môj mladší brat zabehol svoj prvý maratón, vo mne zarezonovala poznámka môjho kolegu, ktorému som v práci spomínal bratov úspech: „Veď vy ste vlastne obaja pretekári, on bežec a tebe preteká brucho.“ To bol moment, kedy som si povedal: dosť.…